- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Apache™ Hadoop ® est un projet de logiciel open source qui peut être utilisé pour traiter efficacement de grands ensembles de données. Amazone EMR facilite la création et la gestion de clusters élastiques entièrement configurés de Amazon EC2 instances en cours d'exécution Hadoop et d'autres applications dans le Hadoop écosystème.

De ce fait, AWS utilise-t-il Hadoop ?

Amazone Services Web les usages l'open source Apache Hadoop technologie informatique distribuée pour faciliter l'accès à de grandes quantités de puissance de calcul pour exécuter des tâches gourmandes en données. Hadoop , la version open source de MapReduce de Google, est déjà utilisée par des sociétés telles que Yahoo et Facebook.

Deuxièmement, que fait AWS EMR ? Amazone Elastic MapReduce ( DME ) est un Amazone Services Web ( AWS ) outil de traitement et d'analyse des mégadonnées. Amazon DME traite le Big Data sur un cluster Hadoop de serveurs virtuels sur Amazone Cloud de calcul élastique ( EC2 ) et Amazone Service de stockage simple (S3).

De cette manière, quelle est la différence entre Hadoop et AWS ?

Hadoop est un framework qui permet de traiter de grands ensembles de données sur plusieurs ordinateurs. Il comprend Map/Reduce (traitement parallèle) et HDFS (système de fichiers distribués). AWS est un entrepôt de données construit sur une technologie propriétaire développée à l'origine par ParAccel. Quelles sont les utilisations courantes d'Apache Hadoop ?

AWS s3 est-il Hadoop ?

S3 est en fait un stockage infini dans le cloud mais HDFS n'est pas. HDFS est hébergé sur des machines physiques, vous pouvez donc y exécuter n'importe quel programme. Vous ne pouvez rien exécuter sur S3 car c'est juste Object Store et non FS.

Conseillé:

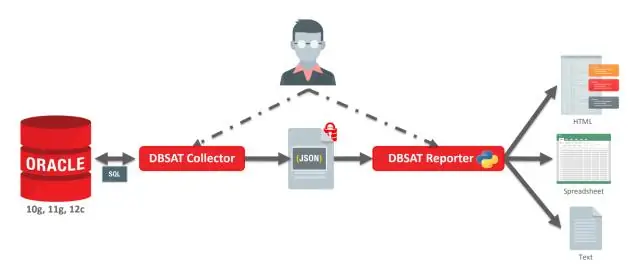

AWS prend-il en charge la base de données Oracle ?

Amazon Web Services prend en charge les bases de données Oracle et offre aux entreprises un certain nombre de solutions pour migrer et déployer leurs applications d'entreprise sur le cloud AWS

AWS RDS prend-il en charge Oracle RAC ?

Q : Oracle RAC est-il pris en charge sur Amazon RDS ? Non, RAC n'est actuellement pas pris en charge

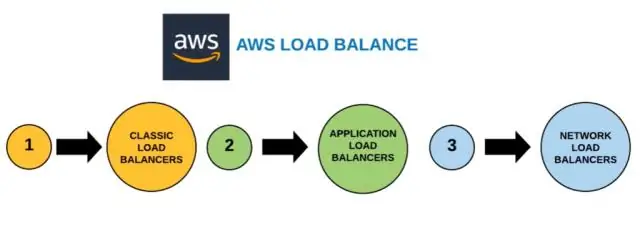

AWS ELB prend-il en charge UDP ?

L'une des limitations les plus importantes d'ELB, ou AWS Classic Load Balancer, est que tout le trafic IP est supposé utiliser un port TCP. Bien que les abonnés demandent la prise en charge UDP depuis plusieurs années (comme documenté sur divers forums Internet), ELB continue de prendre en charge TCP uniquement

Le j7 2016 prend-il en charge la charge rapide ?

Question - La charge rapide est-elle prise en charge dansSamsung Galaxy J7 (2016) ? Réponse - Non, la charge rapide n'est pas disponible sur ce téléphone

AWS prend-il en charge OAuth ?

L'un des protocoles d'autorisation les plus utilisés est OAuth2. AWS API Gateway fournit une prise en charge intégrée pour sécuriser les API à l'aide des étendues AWS Cognito OAuth2. AWS Cognito renvoie la réponse de validation du jeton. Si le jeton est valide, API Gateway validera la portée OAuth2 dans le jeton JWT et l'appel API ALLOW ou DENY