Table des matières:

- Auteur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Ci-dessous, cinq étapes de bonnes pratiques que vous pouvez suivre lors du déploiement de votre modèle prédictif en production

- Spécifiez les exigences de performances.

- Séparer l'algorithme de prédiction de Modèle Coefficients.

- Développez des tests automatisés pour votre Modèle .

- Développer une infrastructure de back-testing et de now-testing.

- Défi puis essai Modèle Mises à jour.

D'ailleurs, que signifie déployer un modèle ?

Déploiement du modèle . La notion de déploiement en science des données fait référence à l'application d'un maquette pour la prédiction à l'aide d'une nouvelle donnée. En fonction des besoins, le déploiement La phase peut être aussi simple que la génération d'un rapport ou aussi complexe que la mise en œuvre d'un processus de science des données reproductible.

Sachez également, comment procédez-vous au déploiement en production ? Dans cet esprit, parlons de quelques moyens de déployer en douceur en production sans risquer la qualité.

- Automatisez autant que possible.

- Créez et emballez votre application une seule fois.

- Déployez toujours de la même manière.

- Déployez à l'aide des indicateurs de fonctionnalité dans votre application.

- Déployez en petits lots et faites-le souvent.

À cet égard, comment déployez-vous des modèles de ML en production ?

Déployez votre premier modèle de ML en production avec une simple pile technologique

- Entraîner un modèle d'apprentissage automatique sur un système local.

- Envelopper la logique d'inférence dans une application de flacon.

- Utilisation de docker pour conteneuriser l'application de flacon.

- Hébergement du conteneur Docker sur une instance AWS ec2 et utilisation du service Web.

Comment déployez-vous des modèles de deep learning ?

Déploiement de votre modèle

- Cliquez sur l'onglet Déployer.

- Sélectionnez la course d'entraînement.

- Entrez le nom du service.

- Choisissez si vous souhaitez le déployer dans votre instance (peut être web ou locale, comme votre cluster d'entreprise) ou dans une instance distante (comme AWS, GCP, Azure, etc.)

- Cliquez sur le bouton Déployer.

Conseillé:

Quelle est la différence entre un modèle de base de données orienté objet et un modèle relationnel ?

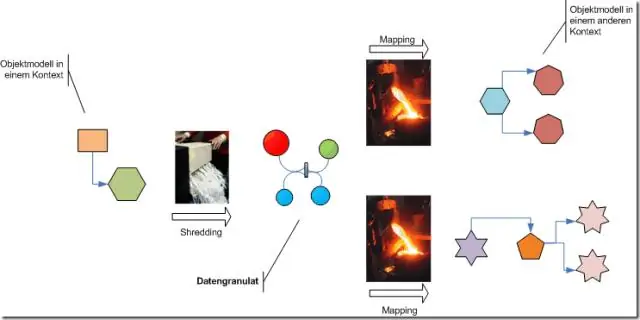

La différence entre la base de données relationnelle et la base de données orientée objet est que la base de données relationnelle stocke les données sous forme de tables contenant des lignes et des colonnes. Dans les données orientées objet, les données sont stockées avec ses actions qui traitent ou lisent les données existantes. Ce sont les différences fondamentales

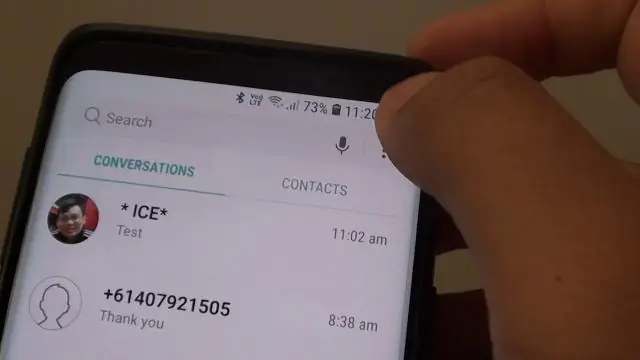

Comment désactiver le texte prédictif sur mon Samsung Galaxy s9 ?

Instructions Ouvrez les paramètres dans la barre des applications ou en appuyant sur l'icône des paramètres en forme d'engrenage dans la barre déroulante. Recherchez et sélectionnez Direction générale. Maintenant, appuyez sur Langue et saisie et choisissez le clavier à l'écran. Sélectionnez le clavier Samsung (ou le clavier que vous utilisez) Ensuite, appuyez sur Smart Typing. Décochez Texte prédictif (correction automatique)

Comment obtenir du texte prédictif sur mon téléphone Samsung ?

Clavier Samsung Appuyez sur l'icône Applications sur l'écran d'accueil. Appuyez sur Paramètres, puis sur Gestion générale. Appuyez sur Langue et saisie. Faites défiler jusqu'à « Claviers et méthodes de saisie » et appuyez sur Clavier Samsung. Sous "Saisie intelligente", appuyez sur Texte prédictif. Appuyez sur le commutateur Texte prédictif sur Activé

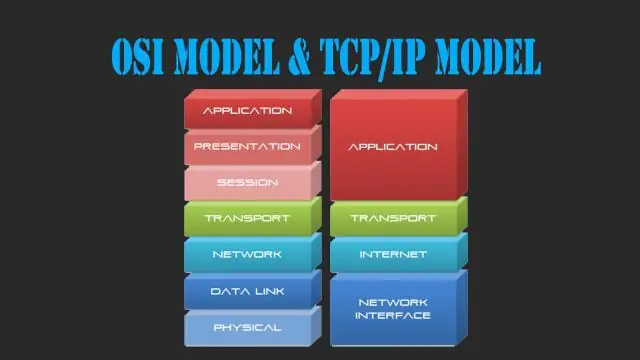

Quelle est la différence entre le modèle OSI et le modèle TCP IP ?

1. OSI est une norme générique indépendante du protocole, agissant comme une passerelle de communication entre le réseau et l'utilisateur final. Le modèle TCP/IP est basé sur des protocoles standard autour desquels Internet s'est développé. C'est un protocole de communication, qui permet la connexion d'hôtes sur un réseau

Comment déployer un modèle de machine learning en production ?

Déployez votre premier modèle de ML en production avec une simple pile technologique Formation d'un modèle d'apprentissage automatique sur un système local. Envelopper la logique d'inférence dans une application de flacon. Utilisation de docker pour conteneuriser l'application de flacon. Hébergement du conteneur Docker sur une instance AWS ec2 et utilisation du service Web