Table des matières:

- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Pour activer le serveur d'historique Spark:

- Créez un répertoire pour les journaux d'événements dans le système de fichiers DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Lorsque la journalisation des événements est activée, le comportement par défaut consiste à enregistrer tous les journaux, ce qui entraîne une augmentation du stockage au fil du temps.

À côté de cela, comment configurer un serveur Spark History ?

Pour activer le serveur d'historique Spark:

- Créez un répertoire pour les journaux d'événements dans le système de fichiers DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Lorsque la journalisation des événements est activée, le comportement par défaut consiste à enregistrer tous les journaux, ce qui entraîne une augmentation du stockage au fil du temps.

De même, comment trouver l'URL de mon serveur Spark History ? Par exemple, pour le serveur d'historique , ils seraient généralement accessibles à l'adresse serveur - URL >:18080/api/v1, et pour une application en cours d'exécution, sur https://localhost:4040/api/v1. Dans l'API, une application est référencée par son ID d'application, [app-id].

De même, qu'est-ce que le serveur Spark History ?

Les Le serveur d'historique Spark est un outil de surveillance qui affiche des informations sur Étincelle applications. Cette information est extrait des données que les applications écrivent par défaut dans un répertoire sur Hadoop Distributed File System (HDFS).

Qu'est-ce que Sparkui ?

L'interface utilisateur Web Spark vous permet de voir une liste des étapes et des tâches du planificateur, des informations environnementales, des informations sur les exécuteurs en cours d'exécution et plus encore. Regardez cette démo de 30 minutes pour en savoir plus sur: Les composants et le cycle de vie d'un programme Spark. Comment votre application Spark s'exécute sur un cluster Hadoop.

Conseillé:

Comment démarrer le serveur GlassFish à partir de l'invite de commande ?

Pour démarrer GlassFish Server à l'aide de la ligne de commande Le numéro de port du serveur GlassFish : Le numéro de port par défaut est 8080. Le numéro de port du serveur d'administration : La valeur par défaut est 4848. Un nom d'utilisateur et un mot de passe d'administration : Le nom d'utilisateur par défaut est admin, et par défaut aucun mot de passe n'est obligatoire

Comment démarrer un serveur bitbucket ?

Pour démarrer Bitbucket Data Center (ne démarre pas l'instance Elasticsearch groupée de Bitbucket) Passez à votre Exécutez cette commande : start-bitbucket.sh --no-search

Comment démarrer mon téléviseur JVC ?

Vidéo du jour Débranchez le JVC de la prise de courant pendant 10 secondes. Rebranchez le téléviseur JVC dans la prise de courant. Maintenez enfoncés les boutons « Menu » et « Volume bas (-) » pendant encore 10 secondes. Juste avant de relâcher ces boutons, maintenez enfoncé le bouton « Power »

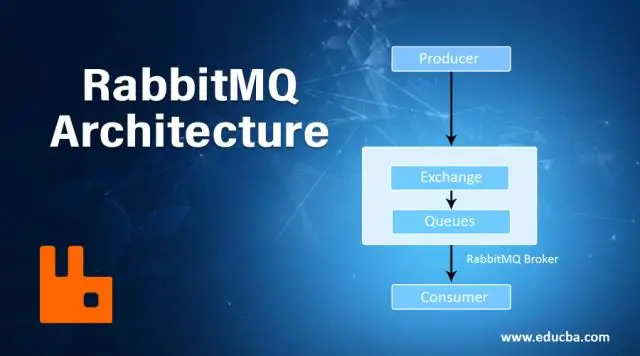

Comment démarrer le serveur RabbitMQ ?

Dans le menu Démarrer de Windows, sélectionnez Tous les programmes > Serveur RabbitMQ > Démarrer le service pour démarrer le serveur RabbitMQ. Le service s'exécute dans le contexte de sécurité du compte système sans qu'un utilisateur soit connecté sur une console. Utilisez le même processus pour arrêter, réinstaller et supprimer le service

Comment démarrer mon CPU en mode sans échec ?

Appuyez sur la touche F8 à un rythme régulier pendant que l'ordinateur démarre, jusqu'à ce que le menu Options avancées de Windows apparaisse. Utilisez les touches fléchées pour déplacer la barre de surbrillance vers l'option Mode sans échec située en haut du menu. Une fois que cela est mis en surbrillance, appuyez sur Entrée