- Auteur Lynn Donovan [email protected].

- Public 2024-01-18 08:24.

- Dernière modifié 2025-01-22 17:24.

- Créer un répertoire dans HDFS . Utilisation: $ hdfs dfs -mkdir

- Lister le contenu d'un répertoire dans HDFS .

- Télécharger un fichier sur HDFS .

- Télécharger un fichier de HDFS .

- Vérifier l'état d'un fichier dans HDFS .

- Voir le contenu d'un fichier dans HDFS .

- Copier un fichier de la source à la destination dans HDFS .

- Copier un fichier depuis/vers le système de fichiers local vers HDFS .

Compte tenu de cela, comment puis-je accéder au répertoire HDFS ?

3 réponses. Il n'y a pas de cd (changer annuaire ) commande dans hdfs système de fichiers. Vous ne pouvez lister que les répertoires et utilisez-les pour atteindre le prochain annuaire . Tu ont pour naviguer manuellement en fournissant le chemin complet à l'aide de la commande ls.

Par la suite, la question est, comment copier un répertoire de HDFS vers local ? Vous pouvez copier les données de hdfs vers le système de fichiers local de deux manières:

- bin/hadoop fs -get /hdfs/source/chemin /localfs/destination/chemin.

- bin/hadoop fs -copyToLocal /hdfs/source/chemin /localfs/destination/chemin.

Tout simplement, qu'est-ce que le répertoire HDFS ?

Dans Hadoop , l'entrée et la sortie d'un travail sont généralement stockées dans un système de fichiers partagé appelé le Hadoop Système de fichiers distribué ( HDFS ). Comme son nom l'indique, HDFS est un système de fichiers distribué sur les nœuds d'un cluster et qui fournit une interface unifiée aux fichiers distribués.

Qu'est-ce que la commande HDFS DFS ?

Commande HDFS pour déplacer des fichiers de la source à la destination. Cette commander autorise également plusieurs sources, auquel cas la destination doit être un répertoire. Usage: hdfs dfs -mv Commander : hdfs dfs -mv /utilisateur/ hadoop /fichier1 /utilisateur/ hadoop /fichier2.

Conseillé:

Comment modifier le répertoire de l'espace de travail dans le pipeline Jenkins ?

Modification globale de l'emplacement de l'espace de travail pour tous les travaux Accédez à Jenkins->Gérer Jenkins->Configurer le système et cliquez sur le bouton Avancé sur le côté droit. Vous pouvez maintenant modifier votre espace de travail et créer un répertoire vers n'importe quel autre emplacement sur votre machine

Comment exécuter un fichier de classe Java dans un autre répertoire ?

Voici les étapes pour exécuter le fichier de classe Java qui se trouve dans un répertoire différent : Étape 1 (Créer la classe utilitaire) : Créer A. Étape 2 (Compiler la classe utilitaire) : Ouvrez le terminal à l'emplacement proj1 et exécutez les commandes suivantes. Étape 3 (Vérifiez si A. Étape 4 (Écrivez la classe principale et compilez-la): Déplacez-vous vers votre répertoire proj2

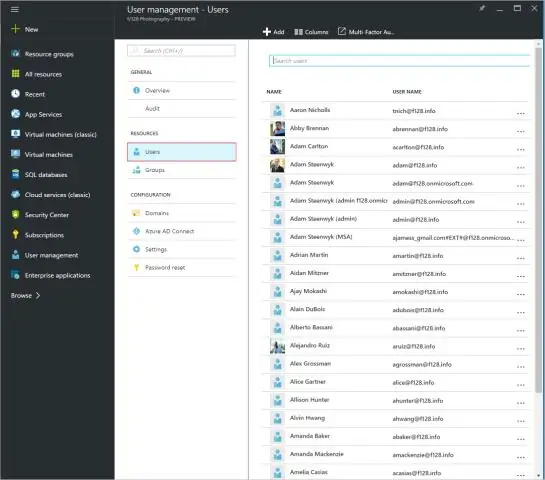

Comment changer le répertoire personnel dans Active Directory ?

Ouvrez Utilisateurs et ordinateurs Active Directory. Sélectionnez une unité d'organisation et sélectionnez tous les utilisateurs dont vous souhaitez modifier leur dossier de départ. Faites un clic droit et accédez aux propriétés. De là, il devrait y avoir un onglet 'Profil'

Quelle commande permet d'afficher un fichier ou un répertoire dans Hadoop ?

Commande Hadoop HDFS ls Description : La commande Hadoop fs shell ls affiche une liste du contenu d'un répertoire spécifié dans le chemin fourni par l'utilisateur. Il affiche le nom, les autorisations, le propriétaire, la taille et la date de modification pour chaque fichier ou répertoire dans le répertoire spécifié

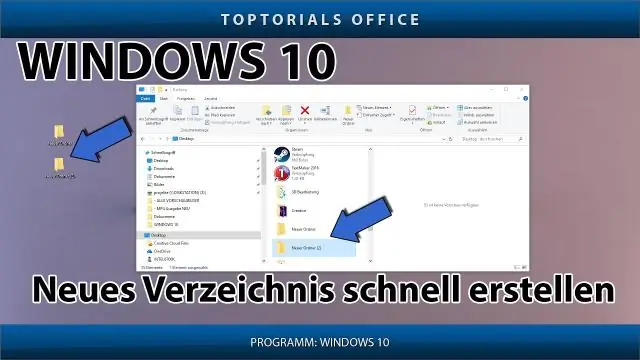

Comment créer un nouveau répertoire sous Windows 10 ?

Pour créer un nouveau répertoire dans Windows 10. Suivez les étapes : a. Cliquez avec le bouton droit sur une zone vide du bureau ou dans la fenêtre du dossier, pointez sur Nouveau, puis cliquez surDossier. Pour créer un nouveau dossier : Naviguez là où vous souhaitez créer un nouveau dossier. Appuyez et maintenez Ctrl + Maj + N. Entrez le nom de dossier souhaité, puis cliquez sur Entrée