Table des matières:

- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Spark peut être Cours à l'aide du planificateur de cluster autonome intégré dans le local mode. Cela signifie que tous les Étincelle les processus sont Cours au sein de la même JVM, une seule instance multithread de Étincelle.

À cet égard, comment exécuter Apache Spark localement ?

Les étapes suivantes montrent comment installer Apache Spark

- Étape 1: Vérification de l'installation de Java.

- Étape 2: Vérification de l'installation de Scala.

- Étape 3: Téléchargement de Scala.

- Étape 4: Installation de Scala.

- Étape 5: Téléchargement d'Apache Spark.

- Étape 6: Installation de Spark.

- Étape 7: Vérification de l'installation de Spark.

De plus, pouvons-nous exécuter Spark sans Hadoop ? Selon Étincelle Documentation, Spark peut fonctionner sans Hadoop . Tu peut exécuter en mode autonome sans pour autant tout gestionnaire de ressources. Mais si tu vouloir Cours en configuration multi-nœuds, tu besoin d'un gestionnaire de ressources comme YARN ou Mesos et d'un système de fichiers distribué comme HDFS , S3 etc. Oui, Spark peut fonctionner sans hadoop.

À côté de ci-dessus, comment exécuter Spark en mode autonome ?

À installer Mode autonome Spark , vous placez simplement une version compilée de Étincelle sur chaque nœud du cluster. Vous pouvez obtenir des versions prédéfinies de Étincelle avec chaque version ou construisez-le vous-même.

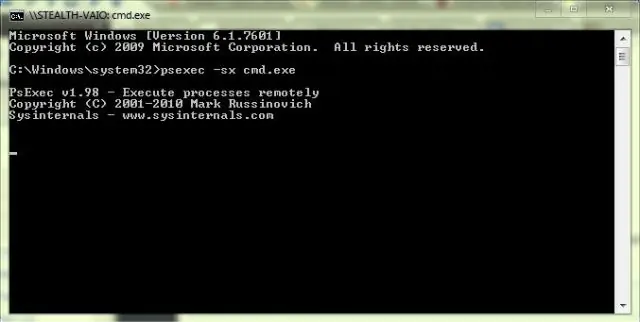

Spark peut-il fonctionner sous Windows ?

UNE Étincelle application pouvez être un les fenêtres -shell script ou il pouvez être un programme personnalisé écrit en Java, Scala, Python ou R. Vous avez besoin les fenêtres exécutables installés sur votre système pour Cours ces candidatures.

Conseillé:

Comment puis-je exécuter mon programme C à l'invite de commande ?

Comment compiler le programme C dans l'invite de commande ? Exécutez la commande 'gcc -v' pour vérifier si vous avez un compilateur installé. Créez un programme c et stockez-le dans votre système. Changez le répertoire de travail où vous avez votre programme C. Exemple : >cd Bureau. L'étape suivante consiste à compiler le programme. Dans l'étape suivante, nous pouvons exécuter le programme

Puis-je exécuter Windows et Mac sur le même PC ?

Si vous possédez un Mac à processeur Intel, vous pouvez exécuter OS X et Windows sur le même ordinateur. La plupart des ordinateurs PC utilisent des puces Intel, ce qui signifie que vous pouvez désormais exécuter les systèmes d'exploitation Windows et OS X sur un ordinateur Mac

LastPass peut-il stocker les mots de passe localement ?

Vos données LastPass Vault (p

Puis-je exécuter Python sur Hadoop ?

Avec un choix entre des langages de programmation comme Java, Scala et Python pour l'écosystème Hadoop, la plupart des développeurs utilisent Python en raison de ses bibliothèques de support pour les tâches d'analyse de données. Le streaming Hadoop permet à l'utilisateur de créer et d'exécuter des tâches Map/Reduce avec n'importe quel script ou exécutable en tant que mappeur ou/et réducteur

Qu'est-ce que le stockage attaché localement ?

DAS est l'abréviation de stockage à connexion directe. Le stockage à connexion directe (DAS), également appelé stockage à connexion directe, est un stockage numérique directement connecté à un ordinateur ou à un serveur. En d'autres termes, DAS ne fait pas partie d'un réseau de stockage. L'exemple le plus connu de DAS est le disque dur interne d'un ordinateur portable ou de bureau