- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

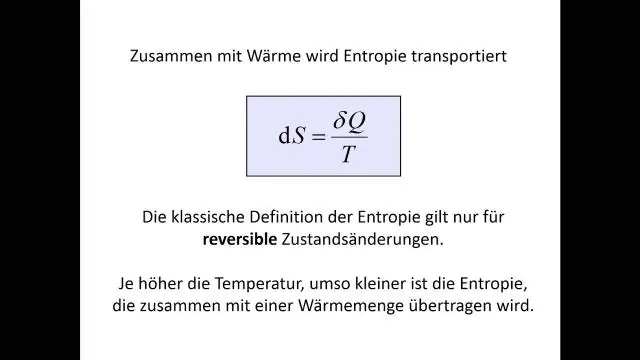

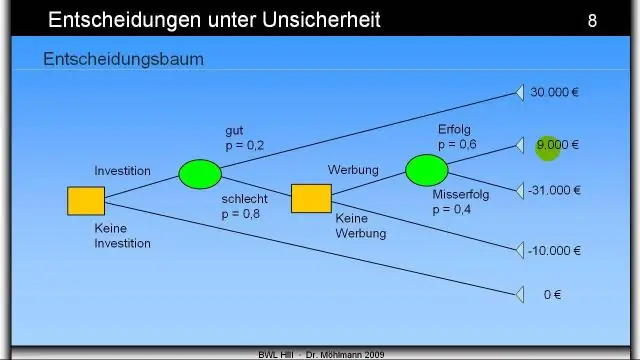

Entropie : UNE arbre de décision est construit de haut en bas à partir d'un nœud racine et implique le partitionnement des données en sous-ensembles contenant des instances avec des valeurs similaires (homogènes). L'algorithme ID3 utilise entropie pour calculer l'homogénéité d'un échantillon.

Les gens demandent également quelle est la définition de l'entropie dans l'apprentissage automatique ?

Entropie , en ce qui concerne apprentissage automatique , est une mesure du caractère aléatoire des informations traitées. Plus le entropie , plus il est difficile de tirer des conclusions à partir de ces informations. Lancer une pièce est un exemple d'action qui fournit des informations aléatoires. C'est l'essence de entropie.

À côté de ci-dessus, qu'est-ce que le gain d'information et l'entropie dans l'arbre de décision ? Les obtenir des informations repose sur la baisse de entropie après qu'un ensemble de données est divisé sur un attribut. Construire un arbre de décision consiste à trouver l'attribut qui renvoie le plus haut obtenir des informations (c'est-à-dire les branches les plus homogènes). Le résultat est le Gain d'informations , ou diminution de entropie.

Sachez également, quelle est la valeur minimale de l'entropie dans un arbre de décision ?

Entropie est le plus bas aux extrêmes, lorsque la bulle ne contient pas d'instances positives ou uniquement des instances positives. C'est-à-dire que lorsque la bulle est pure, le désordre est égal à 0. Entropie est le plus élevé au milieu lorsque la bulle est répartie uniformément entre les instances positives et négatives.

Qu'est-ce que l'entropie dans la forêt aléatoire?

Qu'est-ce que l'entropie et pourquoi l'information gagne en importance dans Décision Des arbres? Nasir Islam Soujan. 29 juin 2018 · 5 min de lecture. Selon Wikipédia, Entropie fait référence au désordre ou à l'incertitude. Définition: Entropie est la mesure de l'impureté, du désordre ou de l'incertitude dans un tas d'exemples.

Conseillé:

Comment fonctionne l'arbre de décision dans R?

L'arbre de décision est un type d'algorithme d'apprentissage supervisé qui peut être utilisé à la fois dans des problèmes de régression et de classification. Il fonctionne pour les variables d'entrée et de sortie catégoriques et continues. Lorsqu'un sous-nœud se divise en d'autres sous-nœuds, il s'appelle un nœud de décision

Quelle est la profondeur d'un arbre de décision ?

La profondeur d'un arbre de décision est la longueur du plus long chemin d'une racine à une feuille. La taille d'un arbre de décision est le nombre de nœuds dans l'arbre. Notez que si chaque nœud de l'arbre de décision prend une décision binaire, la taille peut atteindre 2d+1&moins;1, où d est la profondeur

Comment faire un arbre de décision dans R ?

Que sont les arbres de décision ? Étape 1 : Importez les données. Étape 2 : Nettoyez l'ensemble de données. Étape 3 : Créer un train/ensemble de test. Étape 4 : Construisez le modèle. Étape 5 : Faites une prédiction. Étape 6 : Mesurez les performances. Étape 7 : Réglez les hyper-paramètres

Qu'est-ce qu'un nœud dans un arbre de décision ?

Un arbre de décision est une structure de type organigramme dans laquelle chaque nœud interne représente un « test » sur un attribut (par exemple, si un tirage à pile ou face donne pile ou face), chaque branche représente le résultat du test et chaque nœud feuille représente un étiquette de classe (décision prise après avoir calculé tous les attributs)

Comment créer un arbre de décision dans PowerPoint ?

Dans cet article, je vais personnaliser un modèle de carte mentale d'Envato Elements pour créer un arbre de décision simple. Avec ces bases à l'esprit, créons un arbre de décision dans PowerPoint. Dessinez l'arbre de décision sur papier. Choisissez et téléchargez un modèle MindMap. Formatez les nœuds et les branches. Entrez vos informations