- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

UNE Spark DataFrame est une collection distribuée de données organisée en colonnes nommées qui fournit des opérations pour filtrer, regrouper ou calculer des agrégats, et peut être utilisée avec Étincelle SQL. DataFrames peut être construit à partir de fichiers de données structurés, de RDD existants, de tables dans Hive ou de bases de données externes.

De même, vous pouvez demander, qu'est-ce qu'un DataFrame dans Scala ?

Une collection distribuée de données organisée en colonnes nommées. UNE Trame de données équivaut à une table relationnelle dans Spark SQL. Pour sélectionner une colonne dans le trame de données , utilisez la méthode apply dans Scala et col à Java.

quelle est l'utilisation de allumé dans Scala? ( allumé est utilisé dans Étincelle pour convertir une valeur littérale en une nouvelle colonne.) Puisque concat prend des colonnes comme arguments allumé doit être utilisé ici.

À côté de ci-dessus, quelle est la différence entre RDD et DataFrame dans Spark ?

Spark RDD API - Un RDD signifie Resilient Distributed Datasets. Il s'agit d'une collection d'enregistrements de partition en lecture seule. RDD est la structure de données fondamentale de Étincelle . DataFrame dans Spark permet aux développeurs d'imposer une structure sur une collection distribuée de données, permettant une abstraction de niveau supérieur.

Que fait avecColumn dans Spark ?

Spark avecColonne () fonction est utilisé pour renommer, modifier la valeur, convertir le type de données d'une colonne DataFrame existante et également pouvez être utilisé pour créer une nouvelle colonne, sur ce post, je volonté vous guide à travers les opérations de colonne DataFrame couramment utilisées avec Scala et Pyspark exemples.

Conseillé:

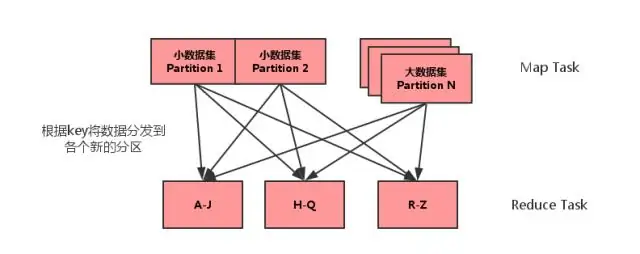

Qu'est-ce que la jointure côté MAP dans Spark?

La jointure côté map est un processus dans lequel les jointures entre deux tables sont effectuées dans la phase Map sans l'intervention de la phase Reduce. Les jointures côté carte permettent à une table d'être chargée en mémoire assurant une opération de jointure très rapide, entièrement réalisée dans un mappeur et cela aussi sans avoir à utiliser à la fois les phases de mappage et de réduction

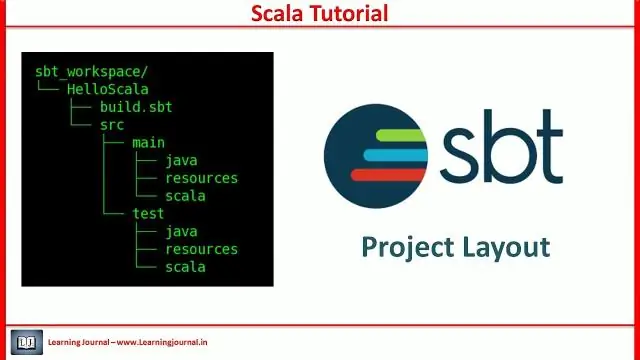

Qu'est-ce que le projet SBT dans Scala ?

Sbt est un outil de génération open source pour les projets Scala et Java, similaire à Maven et Ant de Java. Ses principales caractéristiques sont : Prise en charge native de la compilation du code Scala et intégration avec de nombreux frameworks de test Scala. Compilation, test et déploiement continus

Qu'est-ce que RDD dans Scala?

Les jeux de données distribués résilients (RDD) sont une structure de données fondamentale de Spark. C'est une collection d'objets distribuée immuable. Les RDD peuvent contenir tout type d'objets Python, Java ou Scala, y compris des classes définies par l'utilisateur. Formellement, un RDD est une collection d'enregistrements partitionnés en lecture seule

Qu'est-ce que l'override dans Scala ?

Remplacement de la méthode Scala. Lorsqu'une sous-classe a le même nom de méthode que celui défini dans la classe parent, cela est appelé remplacement de méthode. Lorsque la sous-classe veut fournir une implémentation spécifique pour la méthode définie dans la classe parent, elle remplace la méthode de la classe parent

Est-ce que le show est une action dans Spark ?

2 réponses. show est en effet une action, mais il est suffisamment intelligent pour savoir quand il n'a pas à tout exécuter. Si vous aviez un orderBy, cela prendrait aussi très longtemps, mais dans ce cas, toutes vos opérations sont des opérations de carte et il n'est donc pas nécessaire de calculer l'ensemble de la table finale