- Auteur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

1) Petit problème de fichier dans HDFS : Stockage de beaucoup de petits fichiers qui sont extrêmement plus petite que la taille du bloc ne peut pas être gérée efficacement par HDFS . Lecture à travers petits fichiers impliquent beaucoup de recherches et de nombreux sauts entre les nœuds de données et les nœuds de données, ce qui est à son tour un traitement de données inefficace.

A côté de cela, quels fichiers traitent des problèmes de petits fichiers dans Hadoop ?

1) HAR ( Hadoop Archiver) Des dossiers a été présenté à traiter le problème des petits fichiers . HAR a introduit une couche au-dessus de HDFS , qui fournissent une interface pour déposer accéder. À l'aide de Hadoop commande d'archivage, HAR des dossiers sont créés, qui exécute un CarteRéduire travail pour emballer le des dossiers étant archivé dans plus petite nombre de Fichiers HDFS.

De plus, puis-je faire en sorte que plusieurs fichiers dans HDFS utilisent différentes tailles de bloc ? Défaut Taille de bloquer est de 64 Mo. tu pouvez changez-le en fonction de vos besoins. Pour en venir à ta question oui toi peut créer plusieurs fichiers en variant tailles de bloc mais en temps réel cela volonté pas favoriser la production.

De plus, pourquoi HDFS ne gère pas les petits fichiers de manière optimale ?

Problèmes avec petits fichiers et HDFS Tous déposer , répertoire et bloc dans HDFS est représenté comme un objet dans la mémoire du namenode, dont chacun occupe 150 octets, en règle générale. Par ailleurs, HDFS n'est pas conçu pour accéder efficacement petits fichiers : ce est principalement conçu pour l'accès en streaming de grands des dossiers.

Pourquoi Hadoop est-il lent ?

Lent Vitesse de traitement La recherche de ce disque prend du temps, ce qui rend l'ensemble du processus très lent . Si Hadoop traite des données en petit volume, il est très lent relativement. Il est idéal pour les grands ensembles de données. Comme Hadoop a un moteur de traitement par lots au cœur de sa vitesse de traitement en temps réel est moindre.

Conseillé:

Quel est le problème avec Digg?

De nombreux problèmes de Digg étaient apparents dans son malheureux DiggBar, qui a été lancé en 2009 et a finalement été tué en avril 2010. La barre était vendue comme un raccourcisseur d'URL, mais encadrait les sites Web d'autres personnes - c'est-à-dire que chaque fois que vous visitez une page, vous 'd rester sur Digg avec leur site apparaissant à l'intérieur de la fenêtre

Qu'est-ce qui cause les petits trous dans la roche en plaques ?

De petits trous dans votre plaque de plâtre pourraient également indiquer que vous avez des guêpes des bois. Ils utilisent le bois pour pondre leurs œufs. Une fois que ces œufs éclosent, les larves peuvent passer des années à se frayer un chemin à travers le bois jusqu'à ce qu'elles atteignent le Sheetrock

Quelle est la différence entre les fichiers programme et les fichiers programme 86x ?

Le dossier Program Files standard contient les applications 64 bits, tandis que « Program Files (x86) » est utilisé pour les applications 32 bits. L'installation d'une application 32 bits sur un PC avec Windows 64 bits est automatiquement dirigée vers Program Files (x86). Voir Program Files et x86

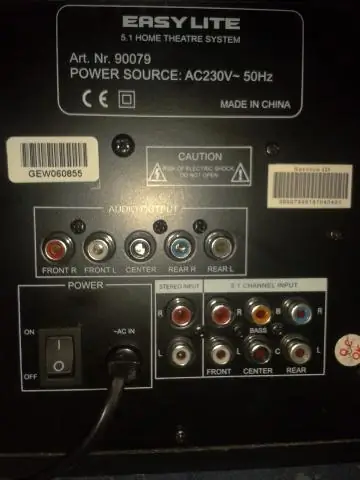

Quel est le problème avec mon son sur mon ordinateur ?

Si votre ordinateur rencontre des problèmes de lecture du son, essayez d'utiliser l'utilitaire de résolution des problèmes de lecture audio pour résoudre le problème. Il recherche les problèmes courants avec vos paramètres de volume, votre carte son ou pilote, et vos haut-parleurs ou écouteurs. Sous Matériel et son, cliquez sur Dépanner la lecture audio

Que sont les signatures de fichiers ou les en-têtes de fichiers utilisés en criminalistique numérique ?

Types de fichiers Une signature de fichier est une séquence unique d'octets d'identification écrite dans l'en-tête d'un fichier. Sur un système Windows, une signature de fichier est normalement contenue dans les 20 premiers octets du fichier. Différents types de fichiers ont des signatures de fichiers différentes; par exemple, un fichier image Windows Bitmap (