Table des matières:

- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Pour activer TensorFlow, ouvrez une instance Amazon Elastic Compute Cloud (Amazon EC2) de la DLAMI avec Conda

- Pour TensorFlow et Keras 2 sur Python 3 avec CUDA 9.0 et MKL-DNN, exécutez cette commande: $ source activate tensorflow_p36.

- Pour TensorFlow et Keras 2 sur Python 2 avec CUDA 9.0 et MKL-DNN, exécutez cette commande:

En conséquence, TensorFlow s'exécute-t-il sur AWS ?

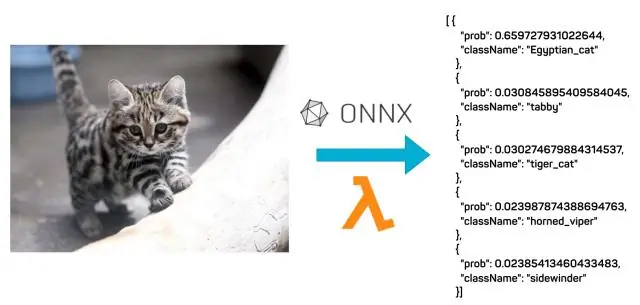

TensorFlow ™ permet aux développeurs de se lancer rapidement et facilement dans l'apprentissage en profondeur dans le cloud. Tu pouvez commencer AWS avec une gestion entièrement TensorFlow expérience avec Amazone SageMaker, une plate-forme pour créer, former et déployer des modèles d'apprentissage automatique à grande échelle.

Sachez également qu'est-ce qu'AWS TensorFlow ? Catégorie: Tensorflow au AWS TensorFlow est une bibliothèque d'apprentissage automatique (ML) open source largement utilisée pour développer des réseaux de neurones profonds (DNN) lourds qui nécessitent une formation distribuée à l'aide de plusieurs GPU sur plusieurs hôtes.

La question est également: comment exécuter l'apprentissage automatique AWS ?

Premiers pas avec le Deep Learning à l'aide de l'AMI AWS Deep Learning

- Étape 1: Ouvrez la console EC2.

- Étape 1b: choisissez le bouton Lancer l'instance.

- Étape 2a: sélectionnez l'AMI AWS Deep Learning.

- Étape 2b: Sur la page des détails, choisissez Continuer.

- Étape 3a: sélectionnez un type d'instance.

- Étape 3b: Lancez votre instance.

- Étape 4: Créez un nouveau fichier de clé privée.

- Étape 5: Cliquez sur Afficher l'instance pour voir l'état de votre instance.

Comment servez-vous un modèle TensorFlow ?

- Créez votre modèle. Importez le jeu de données Fashion MNIST. Entraînez et évaluez votre modèle.

- Enregistrez votre modèle.

- Examinez votre modèle enregistré.

- Servez votre modèle avec TensorFlow Serving. Ajoutez l'URI de distribution TensorFlow Serving en tant que source de package: installez TensorFlow Serving.

- Faites une demande à votre modèle dans TensorFlow Serving. Faites des requêtes REST.

Conseillé:

Comment exécuter des cas de test JUnit dans Eclipse ?

Le moyen le plus simple d'exécuter une seule méthode de test JUnit est de l'exécuter depuis l'éditeur de classe du scénario de test : placez votre curseur sur le nom de la méthode à l'intérieur de la classe de test. Appuyez sur Alt+Maj+X,T pour exécuter le test (ou faites un clic droit, Exécuter en tant que > Test JUnit). Si vous souhaitez réexécuter la même méthode de test, appuyez simplement sur Ctrl + F11

Comment exécuter l'application AVD ?

Exécuter sur un émulateur Dans Android Studio, créez un périphérique virtuel Android (AVD) que l'émulateur peut utiliser pour installer et exécuter votre application. Dans la barre d'outils, sélectionnez votre application dans le menu déroulant des configurations d'exécution/débogage. Dans le menu déroulant de l'appareil cible, sélectionnez l'AVD sur lequel vous souhaitez exécuter votre application. Cliquez sur Exécuter

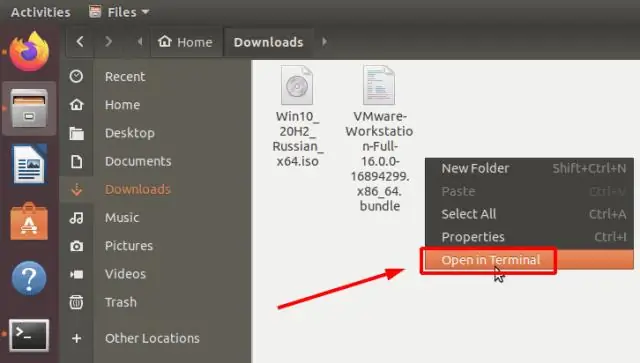

Comment exécuter la commande db2 sous Linux ?

Démarrez une session de terminal ou tapez Alt + F2 pour afficher la boîte de dialogue Linux « Exécuter la commande ». Tapez db2cc pour démarrer le centre de contrôle DB2

Comment exécuter un conteneur Docker dans AWS ?

Déployez les conteneurs Docker Étape 1 : configurez votre première exécution avec Amazon ECS. Étape 2 : créez une définition de tâche. Étape 3 : Configurez votre service. Étape 4 : Configurez votre cluster. Étape 5 : Lancez et affichez vos ressources. Étape 6 : Ouvrez l'exemple d'application. Étape 7 : Supprimez vos ressources

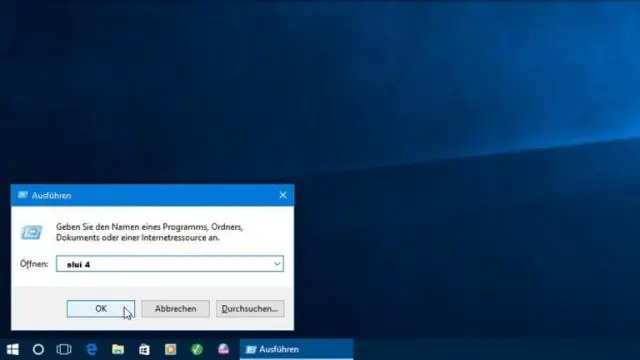

Pouvez-vous exécuter Windows sur AWS ?

Les clients exécutent des charges de travail Windows sur AWS depuis plus d'une décennie. Vous pouvez choisir parmi un certain nombre de versions de Windows Server, y compris la dernière version, Windows Server 2019. En outre, AWS prend en charge tout ce dont vous avez besoin pour créer et exécuter des applications Windows, y compris Active Directory