- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Impala est un moteur de requête de traitement massivement parallèle open source sur des systèmes en cluster comme Apache Hadoop. Il a été créé sur la base du papier Dremel de Google. Il s'agit d'un moteur de requête interactif de type SQL qui s'exécute sur Hadoop Distributed File System (HDFS). Impala utilise HDFS comme stockage sous-jacent.

À ce sujet, qu'est-ce que l'Impala et la ruche ?

Apache Ruche est une norme efficace pour SQL-in-Hadoop. Impala est un moteur de requête SQL open source développé après Google Dremel. Cloudera Impala est un moteur SQL de traitement des données stockées dans HBase et HDFS. Impala les usages Ruche mégastore et peut interroger le Ruche tableaux directement.

De plus, quelle est la meilleure ruche ou Impala ? Apache Ruche peut ne pas être idéal pour l'informatique interactive alors que Impala est destiné à l'informatique interactive. Ruche est basé sur Hadoop MapReduce alors que Impala est Suite comme la base de données MPP. Ruche prend en charge les types complexes mais Impala ne fait pas. Apache Ruche est tolérant aux pannes alors que Impala ne prend pas en charge la tolérance aux pannes.

Également demandé, pourquoi utilisons-nous Impala?

Impala prend en charge le traitement des données en mémoire, c'est-à-dire qu'il accède/analyse les données qui est stockées sur les nœuds de données Hadoop sans mouvement de données. Vous pouvez données d'accès en utilisant Impala en utilisant Requêtes de type SQL. Impala fournit un accès plus rapide aux données dans HDFS par rapport aux autres moteurs SQL.

Qu'est-ce qu'une ruche dans le big data ?

Apache Ruche est un Les données système d'entrepôt pour Les données résumé et analyse et pour l'interrogation de grandes Les données systèmes de la plate-forme open source Hadoop. Il convertit les requêtes de type SQL en tâches MapReduce pour une exécution et un traitement faciles de très gros volumes de Les données.

Conseillé:

Pourquoi le Big Data est un gros problème pour eBay ?

Le site d'enchères en ligne Ebay utilise les mégadonnées pour un certain nombre de fonctions, telles que l'évaluation des performances du site et la détection des fraudes. Mais l'une des façons les plus intéressantes pour l'entreprise d'utiliser la pléthore de données qu'elle collecte est d'utiliser les informations pour inciter les utilisateurs à acheter plus de produits sur le site

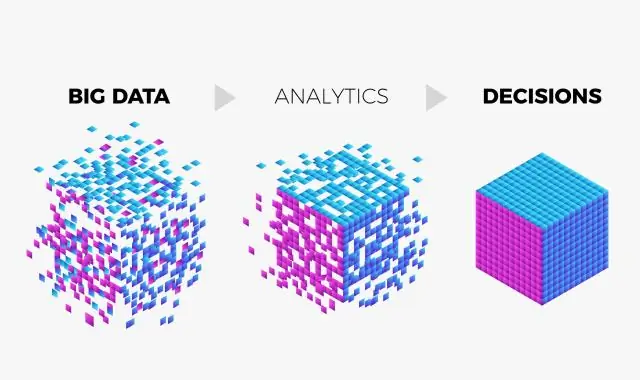

Qu'est-ce que l'ingestion de données dans le Big Data ?

L'ingestion de données est le processus d'obtention et d'importation de données pour une utilisation immédiate ou un stockage dans une base de données. Ingérer quelque chose, c'est "prendre quelque chose ou absorber quelque chose". Les données peuvent être diffusées en temps réel ou ingérées par lots

Quel est le rôle de l'analyste big data ?

Les analystes de Big Data sont chargés d'utiliser l'analyse de données et le CRM pour évaluer les performances techniques d'une organisation et fournir des recommandations sur les améliorations du système. Ces analystes peuvent se concentrer sur des problèmes tels que le streaming, les données en direct et les migrations de données

Comment le big data est-il lié aux prédictions ?

B. Le Big Data fait des prédictions en apprenant aux ordinateurs à penser comme les humains pour déduire des probabilités. C. Le Big Data fait des prédictions en appliquant les mathématiques à d'énormes quantités de données pour déduire des probabilités

Qu'est-ce qu'un cas d'utilisation dans le big data ?

Bien que la majorité des cas d'utilisation du Big Data concernent le stockage et le traitement des données, ils couvrent de multiples aspects commerciaux, tels que l'analyse des clients, l'évaluation des risques et la détection des fraudes. Ainsi, chaque entreprise peut trouver le cas d'utilisation pertinent pour répondre à ses besoins particuliers