- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Commencer le Étincelle Master sur plusieurs nœuds et assurez-vous que ces nœuds ont le même gardien de zoo configuration pour ZooKeeper URL et répertoire.

Informations.

| Propriété système | Sens |

|---|---|

| étincelle .déployer. gardien de zoo .dir | L'annuaire en ZooKeeper pour stocker l'état de récupération (par défaut: / étincelle ). Cela peut être facultatif |

De ce fait, pouvez-vous exécuter Spark localement ?

Spark peut être Cours à l'aide du planificateur de cluster autonome intégré dans le local mode. Cela signifie que tous les Étincelle les processus sont Cours au sein de la même JVM, une seule instance multithread de Étincelle.

Deuxièmement, Spark peut-il être utilisé sans Hadoop ? Selon Étincelle Documentation, Spark peut Cours sans Hadoop . Vous pouvez l'exécuter en mode autonome sans pour autant tout gestionnaire de ressources. Mais si vous voulez exécuter dans une configuration multi-nœuds, vous avez besoin d'un gestionnaire de ressources comme YARN ou Mesos et d'un système de fichiers distribué comme HDFS , S3 etc. Oui, étincelle peut Cours sans hadoop.

A savoir aussi, pourquoi ZooKeeper est utilisé dans Hadoop ?

gardien de zoo dans Hadoop peut être considéré comme un référentiel centralisé où les applications distribuées peuvent mettre et extraire des données. Il est utilisé pour que le système distribué fonctionne comme une seule unité, en utilisant ses objectifs de synchronisation, de sérialisation et de coordination.

Comment Spark autonome fonctionne-t-il ?

Autonome mode est un gestionnaire de cluster simple incorporé avec Étincelle . Cela facilite la configuration d'un cluster qui Étincelle lui-même gère et peut fonctionner sous Linux, Windows ou Mac OSX. C'est souvent la façon la plus simple de courir Étincelle application dans un environnement en cluster. Apprendre, comment installer Apache Spark Au Autonome Mode.

Conseillé:

Est-ce que quelqu'un utilise encore LimeWire ?

Un an après la fermeture, LimeWire est toujours très populaire. LimeWire est fermé depuis près d'un an, mais l'ancien service de partage de fichiers est toujours très populaire auprès des personnes cherchant à télécharger de la musique gratuite et d'autres formes de médias. À un moment donné, les estimations placent LimeWire sur un PC sur trois dans le monde

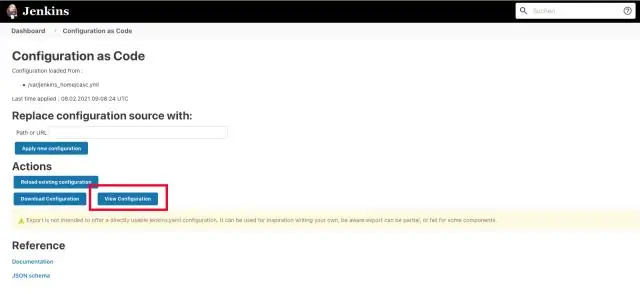

Jenkins peut-il être utilisé comme planificateur ?

Jenkins en tant que planificateur de travaux système. Jenkins est un outil logiciel ouvert, généralement utilisé pour l'intégration continue dans le développement de logiciels. Par exemple, la configuration du commutateur ou l'installation de la politique de pare-feu peut être scriptée et exécutée manuellement ou planifiée dans Jenkins (appelée ici « builds », « jobs » ou « projects »)

Quel langage est utilisé pour la science des données et l'analyse avancée ?

Python De même, quel langage est le mieux adapté à la science des données ? Top 8 des langages de programmation que chaque data scientist devrait maîtriser en 2019 Python. Python est un langage à usage général extrêmement populaire, dynamique et largement utilisé au sein de la communauté de la science des données.

Quel est l'index utilisé pour plusieurs champs dans MongoDB ?

Indices composés

Quelle version de Python Spark utilise-t-il ?

Spark fonctionne sur Java 8+, Python 2.7+/3.4+ et R 3.1+. Pour l'API Scala, Spark 2.3. 0 utilise Scala 2.11. Vous devrez utiliser une version Scala compatible (2.11