- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Gain d'informations = combien Entropie nous avons supprimé, donc

Cela a du sens: plus haut Gain d'informations = plus Entropie supprimé, c'est ce que nous voulons. Dans le cas parfait, chaque branche ne contiendrait qu'une seule couleur après la scission, qui serait zéro entropie !

Par ailleurs, qu'est-ce que le gain d'information et l'entropie dans l'arbre de décision ?

Gain d'informations : Les obtenir des informations repose sur la diminution de entropie après qu'un ensemble de données est divisé sur un attribut. Construire un arbre de décision consiste à trouver l'attribut qui renvoie le plus haut obtenir des informations (c'est-à-dire les branches les plus homogènes). Étape 1: Calculer entropie de la cible.

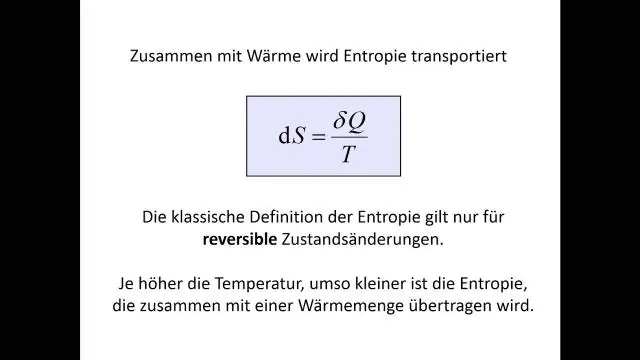

De même, qu'est-ce que l'entropie dans les données ? Informations entropie est le taux moyen auquel l'information est produite par une source stochastique de Les données . La mesure de l'information entropie associé à chaque possible Les données valeur est le logarithme négatif de la fonction de masse de probabilité pour la valeur: où est l'espérance définie par la probabilité.

À cet égard, que signifie l'acquisition d'informations ?

Gain d'informations calcule la réduction de l'entropie ou de la surprise résultant de la transformation d'un ensemble de données d'une manière ou d'une autre. Gain d'informations est la réduction de l'entropie ou de la surprise en transformant un ensemble de données et est souvent utilisé dans la formation des arbres de décision.

Quelle est la définition de l'entropie dans l'arbre de décision ?

Définition : Entropie est la mesure de l'impureté, du désordre ou de l'incertitude dans un tas d'exemples.

Conseillé:

Qu'est-ce qu'un système SIEM de gestion des informations et des événements de sécurité ?

La gestion des informations et des événements de sécurité (SIEM) est une approche de la gestion de la sécurité qui combine les fonctions SIM (gestion des informations de sécurité) et SEM (gestion des événements de sécurité) en un seul système de gestion de la sécurité. L'acronyme SIEM se prononce « sim » avec un e silencieux. Téléchargez ce guide gratuit

Quelle est la définition de l'entropie dans l'arbre de décision ?

Entropie : un arbre de décision est construit de haut en bas à partir d'un nœud racine et implique le partitionnement des données en sous-ensembles contenant des instances avec des valeurs similaires (homogènes). L'algorithme ID3 utilise l'entropie pour calculer l'homogénéité d'un échantillon

Qu'est-ce que la collecte d'informations en recherche ?

Le but de la collecte d'informations est de soutenir la planification du travail de votre organisation pour qu'elle devienne plus inclusive. Il est important d'examiner les faits disponibles - les informations objectives, y compris les données démographiques et les meilleures pratiques

Qu'est-ce que le gain sur un ampli ?

En électronique, le gain est une mesure de la capacité d'un circuit à deux ports (souvent un amplificateur) à augmenter la puissance ou l'amplitude d'un signal de l'entrée au port de sortie en ajoutant de l'énergie convertie d'une alimentation au signal. Il est souvent exprimé en unités de décibels logarithmiques (dB) ('dBgain')

Qu'est-ce que l'entropie dans le text mining ?

L'entropie est définie comme suit : L'entropie est la somme de la probabilité de chaque étiquette multipliée par la probabilité logarithmique de cette même étiquette. Comment appliquer l'entropie et l'entropie maximale en termes de text mining ?