- Auteur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

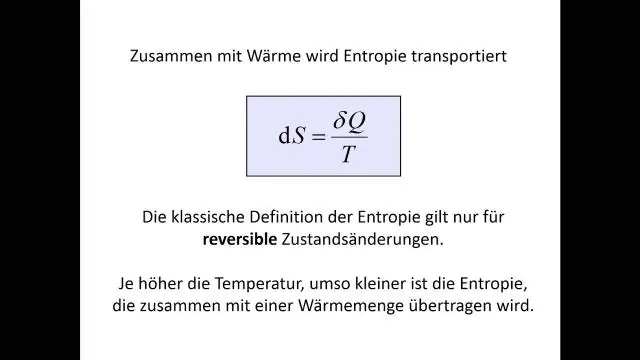

Entropie est défini comme: Entropie est la somme de la probabilité de chaque étiquette multipliée par la probabilité logarithmique de cette même étiquette. Comment puis-je postuler entropie et maxi entropie en terme de extraction de texte ?

Une autre question est la suivante: qu'est-ce que l'entropie dans l'exploration de données ?

Entropie . Un arbre de décision est construit de haut en bas à partir d'un nœud racine et implique le partitionnement du Les données en sous-ensembles qui contiennent des instances avec des valeurs similaires (homogènes). L'algorithme ID3 utilise entropie pour calculer l'homogénéité d'un échantillon.

De plus, quelle est la définition de l'entropie dans l'apprentissage automatique ? Entropie , en ce qui concerne apprentissage automatique , est une mesure du caractère aléatoire des informations traitées. Plus le entropie , plus il est difficile de tirer des conclusions à partir de ces informations. Lancer une pièce est un exemple d'action qui fournit des informations aléatoires. C'est l'essence de entropie.

Les gens demandent également quelle est la définition de l'entropie dans l'arbre de décision ?

Nasir Islam Soujan. 29 juin 2018 · 5 min de lecture. Selon Wikipédia, Entropie fait référence au désordre ou à l'incertitude. Définition : Entropie est la mesure de l'impureté, du désordre ou de l'incertitude dans un tas d'exemples.

Comment calculer l'entropie et le gain ?

Gain d'informations est calculé pour une scission en soustrayant les entropies pondérées de chaque branche de l'original entropie . Lors de la formation d'un arbre de décision à l'aide de ces métriques, la meilleure répartition est choisie en maximisant Gain d'informations.

Conseillé:

Quelle est la définition de l'entropie dans l'arbre de décision ?

Entropie : un arbre de décision est construit de haut en bas à partir d'un nœud racine et implique le partitionnement des données en sous-ensembles contenant des instances avec des valeurs similaires (homogènes). L'algorithme ID3 utilise l'entropie pour calculer l'homogénéité d'un échantillon

Qu'est-ce que text() dans XPath ?

Alors que text() fait référence à la correspondance uniquement avec le texte de l'élément sous forme de chaîne. Cela va être un objet de type Node tandis que l'utilisation de la fonction XPath text() pour obtenir le texte d'un élément n'obtient que le texte jusqu'au premier élément interne

Quels sont les différents types de données dans le data mining ?

Discutons du type de données pouvant être extrait : fichiers plats. Bases de données relationnelles. Entrepôt de données. Bases de données transactionnelles. Bases de données multimédia. Bases de données spatiales. Bases de données de séries temporelles. Internet (WWW)

Qu'est-ce que la proximité dans le data mining ?

Les mesures de proximité font référence aux mesures de similarité et de dissemblance. La similarité et la dissemblance sont importantes car elles sont utilisées par un certain nombre de techniques d'exploration de données, telles que le clustering, la classification du voisin le plus proche et la détection d'anomalies

Qu'est-ce que le gain d'informations d'entropie ?

Gain d'information = combien d'entropie nous avons supprimée, donc cela a du sens : un gain d'information plus élevé = plus d'entropie supprimée, c'est ce que nous voulons. Dans le cas parfait, chaque branche ne contiendrait qu'une seule couleur après la scission, ce qui serait une entropie nulle