- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:46.

- Dernière modifié 2025-01-22 17:24.

Apache Parquet est une colonne libre et open-source orientée Les données espace de rangement format de l'écosystème Apache Hadoop. Il est compatible avec la plupart des Les données frameworks de traitement dans l'environnement Hadoop. Il fournit efficace Les données schémas de compression et d'encodage avec des performances améliorées pour gérer Les données en masse.

Bref, quel est le format de fichier parquet ?

Parquet , une source ouverte format de fichier pour Hadoop. Parquet stocke les structures de données imbriquées dans une colonne plate format . Par rapport à une approche traditionnelle où les données sont stockées dans une approche orientée lignes, parquet est plus efficace en termes de stockage et de performances.

De plus, à quoi sert le parquet ? Parquet est un format de fichier open source disponible pour tout projet de l'écosystème Hadoop. Apache Parquet est conçu pour un format de stockage de données en colonnes plat efficace et performant par rapport aux fichiers basés sur des lignes tels que les fichiers CSV ou TSV.

De plus, comment le format parquet stocke-t-il les données ?

LES DONNÉES BLOC Chaque bloc du parquet le fichier est stocké sous forme de groupes de lignes. Donc, Les données dans un parquet le fichier est partitionné en plusieurs groupes de lignes. Ces groupes de lignes se composent à leur tour d'un ou plusieurs blocs de colonnes qui correspondent à une colonne dans le Les données ensemble. Les Les données pour chaque bloc de colonne écrit sous forme de pages.

Le parquet est-il lisible par l'homme ?

ORC, Parquet , et Avro sont également des machines- lisible formats binaires, c'est-à-dire que les fichiers ressemblent à du charabia à humains . Si tu as besoin un humain - lisible format comme JSON ou XML, vous devriez probablement reconsidérer pourquoi vous utilisez Hadoop en premier lieu.

Conseillé:

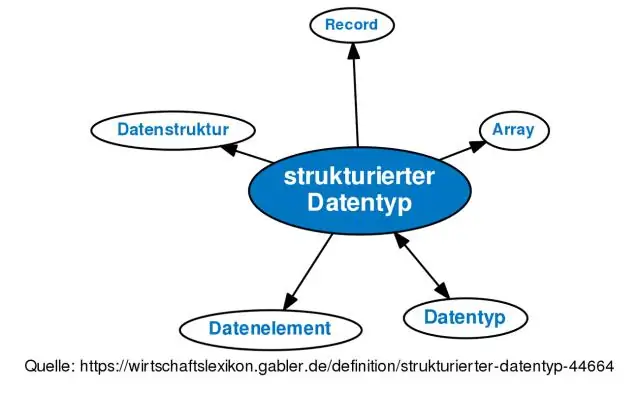

Qu'est-ce que le type de données et la structure des données ?

Une structure de données est une manière de décrire une certaine manière d'organiser des morceaux de données afin que les opérations et les algorithmes puissent être appliqués plus facilement. Un type de données décrit des données qui partagent toutes une propriété commune. Par exemple, un type de données entier décrit chaque entier que l'ordinateur peut gérer

Qu'est-ce que l'exploration de données et qu'est-ce qui n'est pas l'exploration de données ?

L'exploration de données se fait sans aucune hypothèse préconçue, donc l'information qui vient des données n'est pas pour répondre à des questions spécifiques de l'organisation. Pas d'exploration de données : l'objectif de l'exploration de données est l'extraction de modèles et de connaissances à partir de grandes quantités de données, et non l'extraction (extraction) des données elles-mêmes

Pourquoi le stockage de données orienté colonne rend-il l'accès aux données sur les disques plus rapide que le stockage de données orienté ligne ?

Les bases de données orientées colonnes (alias bases de données en colonnes) sont plus adaptées aux charges de travail analytiques car le format de données (format colonne) se prête à un traitement plus rapide des requêtes - analyses, agrégation, etc. D'autre part, les bases de données orientées lignes stockent une seule ligne (et tous ses colonnes) contiguës

Pourquoi la qualité des données est-elle essentielle à la collecte de données statistiques ?

Des données de haute qualité assureront une plus grande efficacité dans la conduite du succès d'une entreprise en raison de la dépendance à des décisions basées sur des faits, au lieu de l'intuition habituelle ou humaine. Intégralité : s'assurer qu'il n'y a pas de lacunes dans les données entre ce qui était censé être collecté et ce qui a été réellement collecté

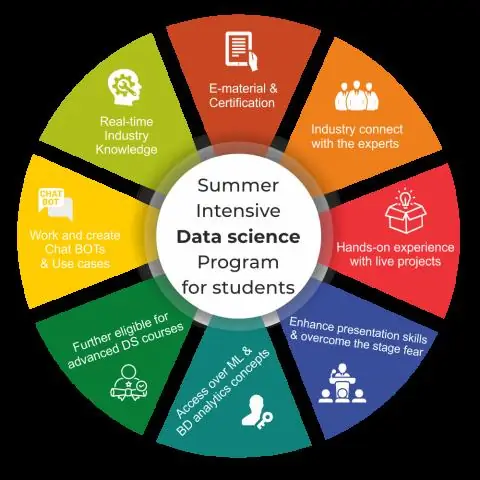

Qu'est-ce que la science des données d'analyse des sentiments ?

L'analyse des sentiments est l'interprétation et la classification des émotions (positives, négatives et neutres) dans les données textuelles à l'aide de techniques d'analyse de texte. L'analyse des sentiments permet aux entreprises d'identifier le sentiment des clients envers les produits, les marques ou les services dans les conversations et les commentaires en ligne